Ce que le joueur d’échecs d’Edgar Poe nous apprend sur la révolution numérique 31 juillet 2013

Par Thierry Klein dans : Speechi.Lu 48 fois | ajouter un commentaire

Dans sa nouvelle consacrée à l’automate joueur d’échecs de Maelzel, Edgar Poe conclut à l’impossibilité qu’une machine puisse jouer aux échecs et, partant, à la nécessité d’une présence humaine (un nain) cachée dans la machine. Les arguments qu’il emploie semblent irréfutables et pourtant, nous savons aujourd’hui qu’ils sont totalement erronés : l’ordinateur joue aux échecs sans intervention humaine et bat n’importe quel joueur, y compris le champion du monde comme l’a montré Deep Blue il y a une quinzaine d’années.

Il est intéressant d’analyser l’origine des erreurs d’Edgar Poe car elles nous aident à comprendre, de façon très fine, en quoi consiste exactement la révolution numérique.

La « démonstration » d’Edgar Poe

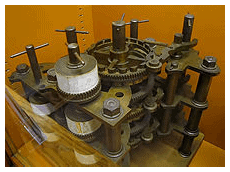

Dès le départ, l’argument d’Edgar Poe est bien de nature numérique. Edgar Poe compare le joueur d’échecs à la machine à calculer de Babbage, qu’on peut définir comme le premier ordinateur.

Edgar Poe remarque, très justement, qu’une machine qui jouerait aux échecs serait de nature bien supérieure à celle de Babbage (la traduction est de Baudelaire, les italiques d’Edgar Poe et c’est Thierry Klein qui souligne).

« Que devrons-nous donc penser de la machine à calculer de M. Babbage ? […] Que penserons-nous d’une mécanique de bois et de métal qui non-seulement peut computer les tables astronomiques et nautiques jusqu’à n’importe quel point donné, mais encore confirmer la certitude mathématique de ses opérations par la faculté de corriger les erreurs possibles ? […] sans la plus légère intervention de l’intelligence humaine ?

On répondra peut-être qu’une machine telle que celle que nous décrivons est, sans aucune comparaison possible, bien au-dessus du Joueur d’échecs de Maelzel. En aucune façon ; elle est au contraire bien inférieure ; pourvu toutefois que nous ayons admis d’abord (ce qui ne saurait être raisonnablement admis un seul instant) que le Joueur d’échecs est une pure machine et accomplit ses opérations sans aucune intervention humaine immédiate. »

Pour Edgar Poe, il y a entre la machine de Babbage et le joueur d’échecs une différence de nature :

« Les calculs arithmétiques ou algébriques sont, par leur nature même, fixes et déterminés.[…] nous pouvons, sans difficulté, concevoir la possibilité de construire une pièce mécanique qui continuera ses mouvements régulièrement, progressivement, sans déviation aucune, vers la solution demandée.[…] Mais dans le cas du Joueur d’échecs il y a une immense différence. Ici, il n’y a pas de marche déterminée. Aucun coup, dans le jeu des échecs, ne résulte nécessairement d’un autre coup quelconque. […] dans les échecs, l’incertitude du coup suivant est en proportion de la marche de la partie.

Il n’y a donc aucune analogie entre les opérations du Joueur d’échecs et celles de la machine à calculer de M. Babbage ; et s’il nous plaît d’appeler le premier une pure machine, nous serons forcés d’admettre qu’il est, sans aucune comparaison possible, la plus extraordinaire invention de l’humanité. »

En conséquence, nous écrit Edgar Poe :

« il est inutile de s’appesantir sur ce point. Il est tout à fait certain que les opérations de l’Automate sont réglées par l’esprit, et non par autre chose. On peut même dire que cette confirmation est susceptible d’une démonstration mathématique, à priori. La seule chose en question est donc la manière dont se produit l’intervention humaine »

L’origine de l’erreur d’Edgar Poe

Dans les années 70, ce texte d’Edgar Poe était couramment enseigné au lycée en classe de français ou de philo pour montrer que l’ordinateur n’était qu’un outil. Il complétait de façon imagée et moderne des enseignements tels que celui du « roseau pensant » de Pascal, qui attribuent une spécificité à l’intelligence humaine, différente par nature de celle d’une machine – et même pour Pascal, différente par nature de celle de l’animal – que Pascal assimile à une machine animée.

Edgar Poe, Pascal, les professeurs de philo se sont trompés : si l’ordinateur bat l’homme aux échecs, s’il le fait sans intervention humaine, c’est bien que la notion humaniste d’une pensée spécifiquement humaine est arriérée. Cette intuition doit être reléguée eux oubliettes, comme la vision de la terre centre de l’Univers ou comme la génération spontanée l’ont, en leur temps, été.

La révolution numérique se situe très exactement au moment où ce point de vue humaniste est infirmé.

L’origine du retard français en informatique

Pourtant, le point de vue humaniste reste le plus répandu en France. Si au moment de l’arrivée des ordinateurs dans les années 1950, ceux-ci avaient su jouer aux échecs, la prise de conscience du côté merveilleux et révolutionnaire de la machine aurait été immédiate. Mais il a ensuite fallu 30 ans pour que les ordinateurs apprennent à jouer correctement aux échecs et 50 ans pour qu’ils battent les êtres humains à coup sûr : leur progression a été lente, graduelle, pénible. La victoire finale de l’ordinateur n’a pas été perçue comme une révolution scientifique mais comme une amélioration marginale.

En France, en particulier, on a interprété cette évolution comme une simple amélioration technologique (les ordinateurs deviennent de plus en plus rapides, ils ont de plus en plus de mémoire) sans s’arrêter au fait principal : une machine suffisamment rapide et dotée d’un bon logiciel dépasse l’homme dans un grand nombre de domaines qui lui semblaient préalablement réservés.

L’informatique, au sens où l’entendent les anglo-saxons qui est celui de « Computer Science » est à la fois une science et une technologie. A partir du moment où les français le recevaient comme un simple outil et la réduisaient donc à une technologie, le retard était pris dans les esprits. Car l’enseignement français privilégie les enseignements généraux (le savoir à long terme, enseigné dans les filières générales) sur l’enseignement des méthodes et des techniques (réservé aux enseignements professionnels).

A l’école, l’informatique s’est retrouvée cantonnée aux filières techniques, qui sont traditionnellement les moins prestigieuses et exclue des filières générales, scientifiques et littéraires. On opposait (on oppose encore) l’informatique en tant que technologie aux sciences fondamentales que sont les mathématiques ou la physique.

A l’inverse, aux Etats-Unis, pays qui privilégie culturellement, comme Tocqueville l’a montré, l’enseignement pratique et utile à plus court terme, le côté « technologique » de l’informatique n’a nui ni à son enseignement, ni à son utilisation dans tous les domaines. Les américains ont fait progresser la technologie (la vitesse des puces, le génie logiciel, les algorithmes de traitement, la taille des mémoires) puis ils ont réalisé presque par hasard, au début des années 2000, qu’une sorte d’effet critique avait été atteint.

La révolution numérique était née.

La révolution numérique est une blessure narcissique.

L’informatique n’a pas eu son Pythagore, son Newton ou son Einstein. La loi de Moore, qui prédit une évolution exponentielle des capacités de traitement des ordinateurs, crée à elle seule la révolution numérique sans avoir besoin d’un génie fondateur : à partir du moment où il a une puissance de calcul suffisante, l’ordinateur peut remplacer l’homme dans un grand nombre de tâches de l’esprit (et du corps) : il pourra conduire, jouer aux échecs, discuter de façon intelligente sur un grand nombre de sujets – c’est à dire passer avec succès le fameux test de Turing.

La liste ci-dessus, qui aurait été impensable il y a 20 ans, n’impressionne aujourd’hui plus grand monde tellement les esprits s’habituent aux avancées techniques. Que dîtes-vous donc de la liste suivante ? D’ici 20 à 30 ans, l’ordinateur pourra aussi noter des dissertations d’élèves, la qualité d’une poésie (en incluant des facteurs « humains » tels que style et sensibilité), faire un diagnostic médical meilleur que celui de tout docteur à partir de quelques photos et enregistrements du patient, déterminer très jeune les aptitudes d’un élève en maths ou en français de façon à mieux l’orienter dans sa scolarité, prédire les épidémies, prévenir des heures ou des jours à l’avance des risques de crise cardiaque, plusieurs mois à l’avance des risques de cancer ou de dépression.

Et si cet inventaire « à la Prévert », dont le principal défaut est d’être gravement incomplet, vous fait douter, c’est que vous êtes encore victimes de votre complexe humaniste. Freud parle des trois blessures narcissiques que la science a infligées à l’humanité. La révolution copernicienne sort l’homme du centre de l’univers, la révolution darwinienne en fait une espèce animale fruit de l’évolution comme les autres, la révolution freudienne montre que l’homme n’est jamais maître à son propre bord. Il faut maintenant en rajouter une quatrième, la révolution numérique, qui enlève sa spécificité à l’intelligence humaine. L’intelligence humaine est dépassée par les machines. Peut-être même l’homme est-il destiné à ne devenir qu’un simple outil, ou un simple ensemble de capteurs, envoyant des données traitées par des machines calculantes et pensantes.

Des machines tels que Google ou Facebook, qui analysent des données entrées par des humains, sous forme de recherches Internet ou de mails, pour leur servir de façon toujours plus intelligente des bandeaux de publicité toujours plus pertinents, ciblant simultanément leurs besoins conscients et inconscients grâce à un simple algorithme, atteignant ainsi une qualité de ciblage inégalée jusqu’alors, préfigurent cette nouvelle ère.

L’informatique est à la fois une technologie et une science

L’informatique est une science qui repose sur des objets abstraits (par exemple, les algorithmes dont le degré d’universalité est du domaine mathématique), mais c’est aussi une technologie puisque ces objets sont destinés à être implémentés au sein de machines et que les effets de la science sont très largement fonction de la qualité de cette implémentation, qui relève du domaine de la technologie. Ces deux aspects indissociables devraient être enseignés comme tels à l’école, dès la 6ème dans les filières générales, y compris littéraires.

Les lecteurs de ce blog savent que je milite avec ferveur pour l’introduction de l’informatique dès la 6ème. La principale objection qu’on m’oppose est que cette tentative aurait été faite, sans succès, au moment du plan calcul à la fin des années 1970. Mais, outre que le plan calcul a été exécuté en dépit du bon sens, ni les programmes ni les matériels choisis n’étant adaptés aux professeurs et aux élèves, l’importance révolutionnaire de l’informatique est une donnée nouvelle qui n’a que 10 à 15 ans. Les puissances de calcul disponibles dans les années 70 empêchaient que les ordinateurs puissent empiéter sur le domaine « spécifiquement humain ». L’informatique était certes déjà une science, et donc en ce sens, pouvait être enseignée avec profit à l’école mais son impact sur le monde restait alors mineur, inférieur à celui d’une science comme la chimie.

Ce qui a changé – et ce qui définit le terme « révolution numérique », c’est que les effets de la science informatique sont devenus immenses, à tel point que la plupart des progrès techniques et scientifiques de demain sont liés à la progression de l’informatique même.

La révolution numérique annonce la fin des sciences.

La science consiste à créer des modèles de moins en moins faux et à les valider par l’expérience. Le modèle de Newton est dépassé par celui d’Einstein, lui-même en contradiction avec le modèle quantique. Mais, quand la puissance des ordinateurs devient gigantesque, il devient possible d’analyser des pétaoctets de données sans modèle prédéfini et de laisser l’ordinateur y rechercher des motifs de nature statistique. Plus besoin de modèle scientifique génial – et forcément faux – pour avancer, l’ordinateur et les données suffisent. La méthode scientifique est devenue obsolète.

Ces techniques sont déjà largement utilisées en biologie et en physique (voir l’article fondateur de Chris Anderson sur ce sujet). Plus la puissance des ordinateurs augmente, plus l’influence de l’informatique devient majeure sur toutes les sciences, à l’exception notable des mathématiques dont l’informatique en tant que science est une des branches. L’informatique en tant que technologie devient un levier indispensable au progrès des autres sciences, remplaçant souvent l’outil mathématique lui-même.

L’humanisme au temps du numérique.

Le mot « humanisme » est un terme en lui-même paradoxal. Il est évidemment dès le départ associé aux lumières, à la Raison et au progrès scientifique. Mais il met aussi, inconsciemment et peut être religieusement, l’homme au centre et cet apriori est évidemment a-copernicien et non scientifique.

Les humanistes ont cru à la fois à la science et à « l’exception humaine ». Mais jusqu’à présent, la science a réduit le domaine de l’exception humaine, infligeant à l’homme les blessures narcissiques évoquées plus haut, la blessure infligée par la révolution numérique étant peut être la plus cruelle de toutes.

Remettre l’Homme au centre du monde apparaît aujourd’hui impossible. L’humanisme perdrait tout son sens et ne serait plus qu’un obscurantisme arriéré s’il n’était pas associé à la raison.

Ce qui reste à l’homme, c’est la possibilité de comprendre, de contrôler et de faire progresser son univers, ce qui n’est pas rien, car la façon dont fonctionnent réellement les machines est aujourd’hui largement incomprise.

La capacité à coder, de même que la lecture ou l’écriture, devenue essentielle pour contribuer de façon pleine et entière à la société d’aujourd’hui, qui résulte de la révolution numérique.

« L’enseignement de l’informatique devra d’abord donner à tous les citoyens les clés du monde du futur afin qu’ils le comprennent et puissent participer en conscience à ses choix et à son évolution plutôt que de le subir en se contentant de consommer ce qui est fait et décidé ailleurs. »[1]

Berners-Lee, l’inventeur de l’internet, remarque justement qu’aujourd’hui :

“Ceux qui savent développer peuvent réaliser des choses incroyables… Il est urgent de réduire le décalage entre les usages de l’informatique et la connaissance de l’informatique en tant que science et ce dès les plus petites classes : un quart de la planète est connecté au web, seuls ceux qui savent programmer peuvent agir.”

Un citoyen qui ne comprend pas de façon profonde le mode de fonctionnement des machines, qui n’est pas capable de les utiliser à son profit, pour agir est un esclave. Esclave des machines certes, mais surtout esclave des concepteurs des machines dans un monde où « Le code fait loi ».

Rabelais, un des premiers à avoir perçu le paradoxe humaniste écrivait que « Science sans conscience n’est que ruine de l’âme ».

En étendant le sens du mot conscience, qui devient aujourd’hui « contrôle », « compréhension » des machines, en tant que levier pour façonner le monde selon la volonté de l’homme, on peut actualiser la notion d’humanisme. Avec la science, « malgré tout », même si ses résultats nous déplaisent, mais pas contre l’Homme.

[1] Rapport de l’Académie des Sciences, mai 2013.

Billets associés :- Qu’y a-t-il de commun entre le robot Asimo de Sony et le joueur d’échec de Maezel ?

- “L’école doit apprendre à lire, écrire, compter et programmer”

- Kasparov, l’intelligence humaine et la révolution numérique.

- Grandeur et faiblesses de l’enseignement de spécialité informatique en classe de première : une analyse critique

- Les conséquences sociales des évaluations sur les enseignants et sur la liberté pédagogique